从科学研究到工业生产再到衣食住行,算力正像水和电一样渗透到生产生活的点点滴滴,特别是随着近两年来AI的火热,引发了算力需求的进一步增长,根据《2022-2023全球计算力指数评估报告》数据,综合全球15个主要国家来看,AI算力支出占总算力支出的比重到2025年将达到25%。

身处AI时代,算力是基础,GPU/CPU是砖头,能够搭建起算力所需的基础设施,而云计算则提供了进一步的组织服务能力,可以将基础设施提供的算力调动起来,为人工智能应用的落地提供更多可能。

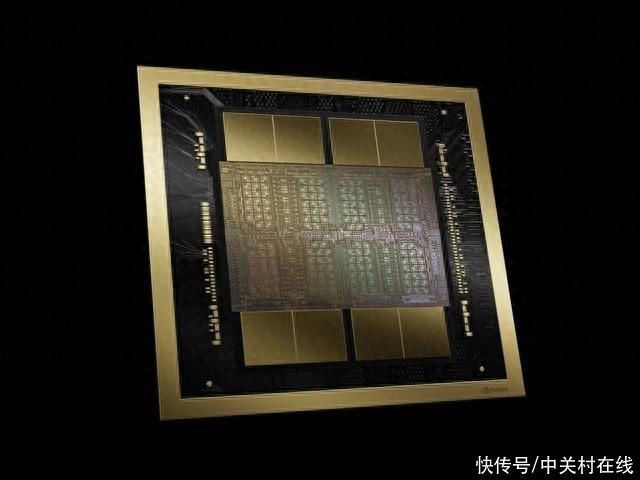

就在不久前被称作“科技春晚”的GTC 2024大会上,英伟达宣布全新推出的NVIDIABlackwell GPU平台即将登陆亚马逊云科技,客户可以在亚马逊云科技上使用基于NVIDIA GB200 Grace Blackwell Superchip和B100 Tensor Core GPUs的基础设施,从而帮助客户更快、更大规模、更低成本地构建和运行万亿参数大模型。

云上AI算力新王登基

从文本生成模型ChatGPT到文生视频模型Sora,人工智能大模型的发展日新月异,而在大模型研发领域,万亿级参数规模此前还算是一道门槛。根据公开的报道,去年年中发布的GPT4的模型参数是1.8万亿,由8个220B模型组成;前不久发布的Claude3模型没有公布参数规模,而马斯克最新开源的Grok大模型参数是3140亿参数规模。英伟达在今年GTC 2024上发布的Blackwell架构GPU,目标就直指万亿参数规模大模型。

作为英伟达在GTC2024上推出的最新GPU产品,NVIDIA B200 GPU包含了2080亿个晶体管,而NVIDIA GB200包含了两个B200 GPU和一个Grace CPU。在具有1750亿个参数的GPT-3大语言模型基准测试中,GB200性能是H100的7倍,训练速度是H100的4倍,成本和能耗上GB200比H100降低了25倍。

亚马逊云科技将在云上提供配置GB200 NVL72的英伟达Blackwell平台,该平台具备配备72颗Blackwell GPU和36颗Grace CPU,通过第五代NVIDIA NVLink互连。亚马逊云科技还将为该平台提供强大的EFA网络连接、高级虚拟化的Amazon Nitro系统和Amazon EC2 UltraClusters超大规模集群等技术支持,客户能够在亚马逊云科技上扩展至数千个GB200 Superchips。

此外,亚马逊云科技还计划提供配备基于新的英伟达B100 GPU的Amazon EC2实例,以在Amazon EC2 UltraClusters中进行大规模部署。此前,亚马逊云科技已经推出了基于英伟达H100芯片的Amazon EC2 P5实例,客户能够在云上将其P5实例扩展到超过2万个英伟达H100 GPU。后续还会提供可短期使用这些实例的EC2 Capacity Blocks for ML功能,以帮助客户更好地安排云上生成式AI开发进程。

与此同时,GB200芯片同时也在亚马逊云科技和英伟达共同开发的AI平台NVIDIA DGX Cloud上可用,这是一个在亚马逊云科技上双方共同开发的AI平台,为企业开发者提供构建和部署先进生成式AI模型所需的专用基础设施和软件。

“亚马逊云科技与英伟达的合作可以追溯到13年前,那时我们共同推出了世界上第一个亚马逊云科技上的GPU云实例,而今天我们为客户提供了最广泛的英伟达GPU解决方案。英伟达下一代Grace Blackwell处理器是生成式AI和GPU计算的标志性事件。当结合亚马逊云科技强大的Elastic Fabric Adapter网络、Amazon EC2 UltraClusters的超规模集群功能,以及Amazon Nitro高级虚拟化系统及其安全功能时,我们就能够使客户更快、更大规模且更安全地构建和运行具有数万亿参数的大型语言模型。”亚马逊云科技首席执行官Adam Selipsky总结道。

为云上AI开发构筑安全的铜墙铁壁

被发明的十年后,互联网防护技术和产业链才开始补齐,与之相对的,在大模型诞生后不到半年的时间里,围绕着模型安全、数据安全、内容安全的讨论,就已经不绝于耳。而通过此次合作,亚马逊云科技与英伟达又将生成式AI安全向前推进了一步。

首先,Amazon Nitro系统与英伟达GB200结合能够阻止未授权个体访问模型权重,保护模型权重的安全至关重要,模型权重是模型在训练过程中学习到的参数,对于模型做出预测的能力至关重要。

其次,GB200支持对GPU间的NVLink连接物理加密以及CPU和GPU间的数据传输加密,同时还能够利用Amazon EFA对分布式训练和推理过程的数据进行加密。受益于Amazon Nitro系统,GB200系统能够将CPU和GPU的输入/输出功能卸载至专门的硬件中,以提供更加一致的性能,其增强的安全性可以在客户端和云端全程保护客户的代码和数据在处理过程中的安全。这一独有的功能已由领先的网络安全公司NCC Group进行了独立验证。NCC Group的报告指出“Nitro系统通过从硬件层面到系统的部署和终止的全过程管理,实现了安全目标,亚马逊云科技没有其他替代的访问NitroEC2主机系统的路径。”

最后,亚马逊云科技一直秉承着客户拥有并能够始终控制其数据,并确保数据不会与第三方模型提供者共享的理念,从而确保云上AI开发的安全性。

Ceiba AI超算为NVIDIA AI开发提供强大助力

去年年底的亚马逊云科技2023 re:Invent全球大会上,亚马逊云科技与NVIDIA共同宣布了Project Ceiba超级计算机项目,这是当时世界上最快的AI超级计算机之一,计算性能为65exaflops。

如今随着英伟达GB200的发布,Ceiba项目也迎来了最新进展,新的Ceiba项目拥有20736颗B200 GPU的超级计算机,采用新型NVIDIA GB200 NVL72系统构建,该系统利用第五代NVLink技术连接10368颗NVIDIA Grace CPU。系统还通过亚马逊云科技的第四代EFA网络进行扩展,为每个Superchip提供高达800Gbps的低延迟、高带宽网络吞吐量,能够处理高达414exaflops的AI计算量。

这也意味着在四个月内,Ceiba AI超算的性能就翻了6倍。

英伟达表示,他们的AI团队将利用Ceiba推进大语言模型、图形(图像/视频/3D生成)与仿真、数字生物学、机器人技术、自动驾驶汽车、NVIDIA Earth-2气候预测等领域的AI技术,以帮助英伟达推动未来生成式AI的创新。

携手推进生成式AI在医疗健康与生命科学领域的应用

在生成式AI取得爆炸式发展的今天,越来越多的医疗保健和生命科学组织更加迫切地转向技术,将其作为业务差异化的竞争优势。亚马逊云科技与英伟达在利用计算机辅助的药物发现领域进行合作拓展,推出了新的NVIDIA BioNeMo基础模型,用于生成化学、蛋白质结构预测,以及理解药物分子与目标的相互作用。这些新模型将很快在Amazon HealthOmics上提供,这是一个专为帮助医疗保健和生命科学组织存储、查询和分析基因组、转录组及其他组学数据而设计的专用服务。

此外,Amazon HealthOmics和英伟达医疗保健团队还合作推出生成式AI微服务,以推进药物发现、医疗技术和数字健康领域的发展,该服务提供一个新的GPU加速的云端服务目录,涵盖生物学、化学、成像和医疗保健数据,以便医疗企业能够在亚马逊云科技上利用生成式AI的最新成果。

正如英伟达创始人兼首席执行官黄仁勋所说的那样,人工智能正在以前所未有的速度推动突破,导致新的应用、商业模式和跨行业的创新。英伟达与亚马逊云科技的强强联手,正在加速新的生成式AI能力的发展,并为千行百业提供前所未有的计算能力,以推动可能性的边界。

(8629905)

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com