寻找AI大模型实际的应用场景,无疑是当下整个AI业界的一个重要议题。由于一年半前ChatGPT凭借着出色的自然语言对话能力一炮而红,自然而然用AI大模型来为智能客服赋能就成为了热门项目。然而最近知名市场调查机构Gartner发布的报告,却为“大模型客服”的未来蒙上了一层阴影,因为许多人对于智能客服的抵制要远比想象中更为激烈。

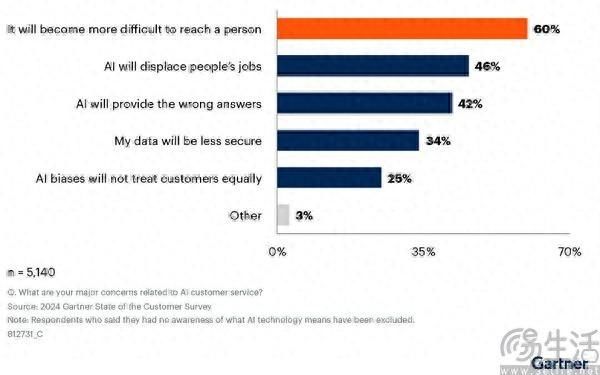

根据Gartner在2023年12月对全球5728名受访者进行的调查结果显示,哟高达64%的受访者表示不希望客服使用AI,53%的受访者如果发现某家公司的客服使用了AI,就会考虑转向竞争对手。一个很有意思的现象,是作为人工客服的“代餐”,智能客服从一开始似乎就没有被消费者所接受,而备受业界期待的AI大模型也未能改变这一点。

大规模使用智能客服无疑是“降本增效”的代表,而用机器来代替人工降低成本,则是许多企业青睐人工智能的关键所在。由于人工客服的服务时间相对有限、服务标准化程度难以保障,再加上人员流动性大、培训成本高,以至于有相当多的企业都会将客服中心放到人力成本更低的地方。但即便如此,运营一个客服中心的成本还是远高于搭建或购买一套智能客服系统。

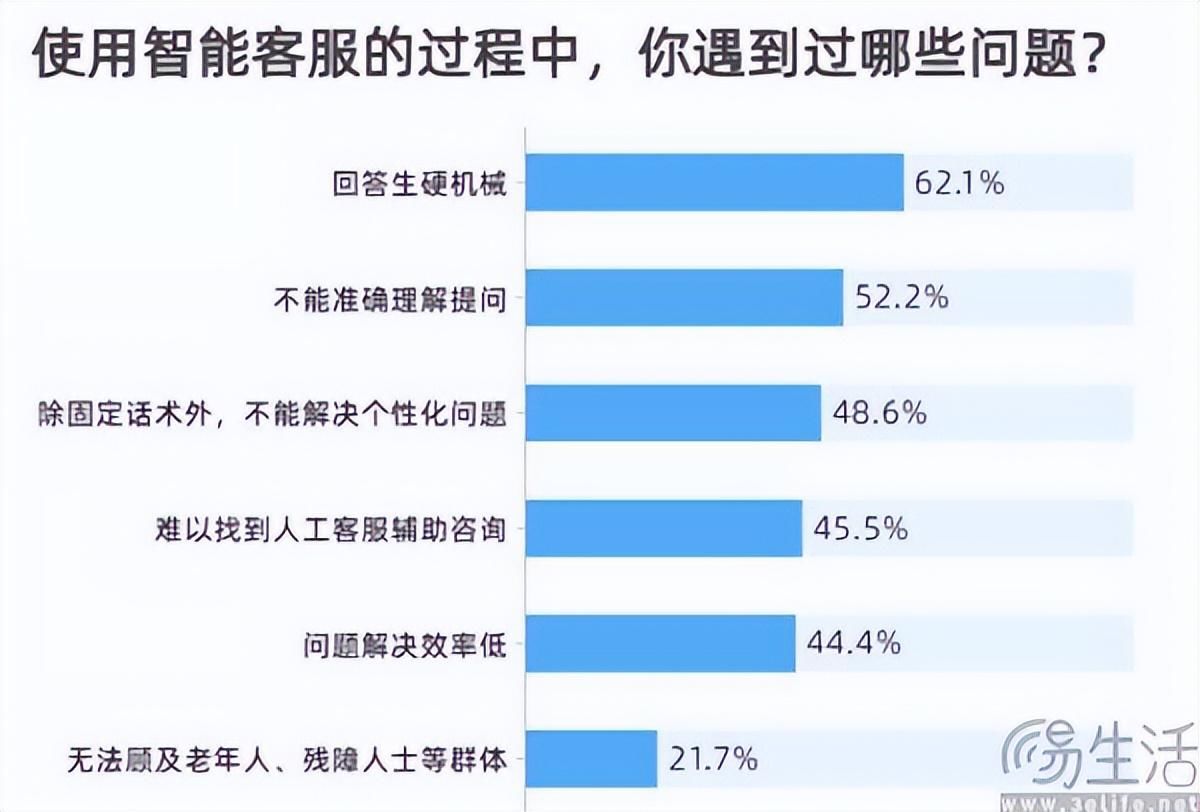

在AI大模型出现之前,智能客服的痛点就在于“不智能”,回答问题也基本只能机械地照本宣传、不能准确理解提问、不能解决个性化问题。彼时智能客服的能力有限,仅局限于解决重复性或是有标准的流程化问题。比如服饰鞋帽产品,消费者在下单前可能会咨询关于尺码、洗涤方式、优惠促销信息等问题,下单后则可能出现需要修改送货地址,或是未收到货、商品质量不符合预期等情况。对此,标准话术即可解决。

但如果消费者希望了解面料材质是否会导致某种过敏这类相对生僻的问题时,智能客服就有力未逮了,因为智能客服或许真的不知道答案。

彼时的智能客服由于高度依赖知识库,一旦问题超出知识库的范畴,为了避免对话中断、让消费者产生客服逃避问题的感受,智能客服的设计者就会使用固定的套词来“打圆场”。但也正是这种勉强维持对话的状态,让消费者会产生“一拳打在棉花上”的感觉,所以智能客服也被不少网友戏称为“机气人”。

要知道在使用搜索引擎已经成为网民的基础技能,且存在知乎、抖音、小红书等多样化内容平台的情况下,真正容易被解决的问题根本就不需要客服的介入。所以绝大多数需要咨询客服的问题,往往是消费者在网上找不到答案,选择联系客服就是希望可以通过对方的专业回答来解决问题。结果却面对一问三不知的智能客服,所产生的挫败感也就可想而知了。

ChatGPT、或者说AI大模型的出现,则给了业界变革智能客服的曙光。传统智能客服的缺陷无外乎自然语言理解能力不足、缺乏上下文记忆功能、输出内容机械生硬,而ChatGPT则已经证明了在Scaling laws(尺度定律)的加持下,参数量越大、数据集规模越大、算力消耗越大,大语言模型的性能就越好,也越能像真人一样对话、乃至与人类共情。

大模型的语言理解能力和内容生成能力被认为有望解决智能客服“不智能”的痛点,所以如果大模型客服也能实现类似人工客服的效果,想必消费者对于电话对面到底是人还是机器并不介意。然而遗憾的是,大模型客服并没有能媲美人工客服。为什么即使有AI大模型赋能,许多用户对于智能客服依然不接受呢?是因为AI大模型赋能的智能客服,并没能为消费者提供合格的体验。

在Gartner的相关报告中,有42%的受访者担忧AI会提供错误的答案,就能够很好的解释这一点。以往智能客服属于能力有限,不知道、不能理解的问题会推诿,可一旦有了大模型的加持,情况就开始发生变化。相信用过ChatGPT、文心一言等大语言模型的朋友都会有类似的体验,那就是同样一个问题,只要修饰一下提示词(Prompt),无论正反方向,AI都能给出看起来自洽的回答。

从来没有存在过的事情都能给用户编出来,这就是ChatGPT目前的问题。然而约束大模型、从而避免其一本正经地胡说八道,这是OpenAI至今都没能做到的事情,更遑论其他厂商,因此大模型客服会给出错误答案,还真不是消费者杞人忧天。曾经的智能客服是不说,现在的智能客服会胡说,作为消费者显然都是不愿意看到的。

更致命的问题是相比于人工客服,智能客服无法承担责任。就像之前有个笑话说的那样,AI时代95%的会计都会失业是假话,因为AI不能代替人类坐牢。正是因为AI不能承担责任,所以企业往往也不会给予智能客服足够的权限,导致了即便有大模型的加持,智能客服真的知道消费者在说什么,但由于没有权限,还是只能用套话来应付消费者,而人工则好歹还会请示上级。

一方面智能客服可能会胡说八道,另一方面没有权限的智能客服什么也做不了,所以要让消费者接受就无异于痴人说梦了。

友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com