友情提示

本站部分转载文章,皆来自互联网,仅供参考及分享,并不用于任何商业用途;版权归原作者所有,如涉及作品内容、版权和其他问题,请与本网联系,我们将在第一时间删除内容!

联系邮箱:1042463605@qq.com

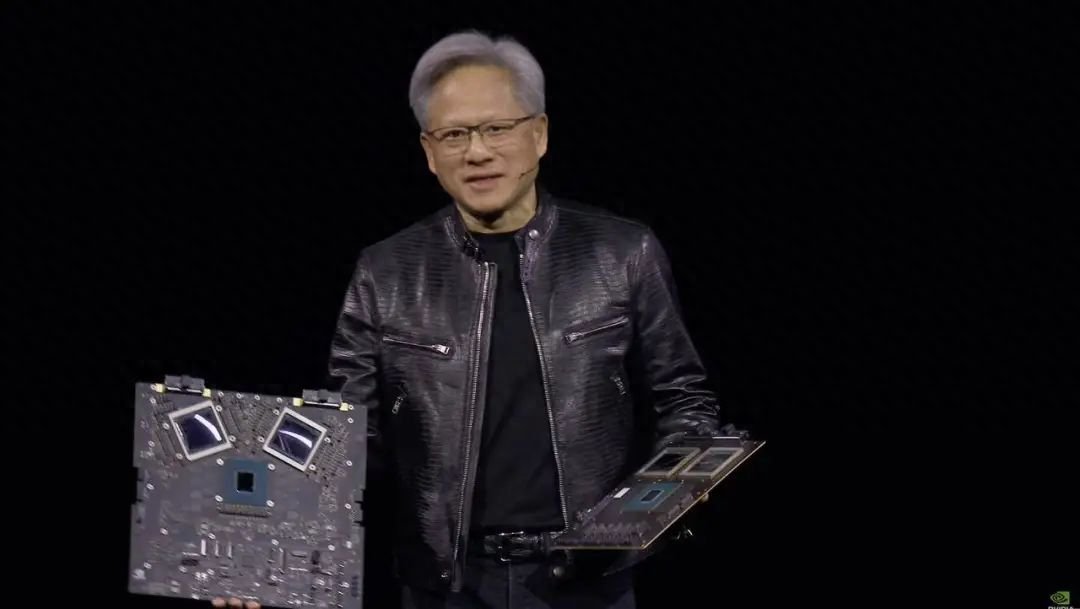

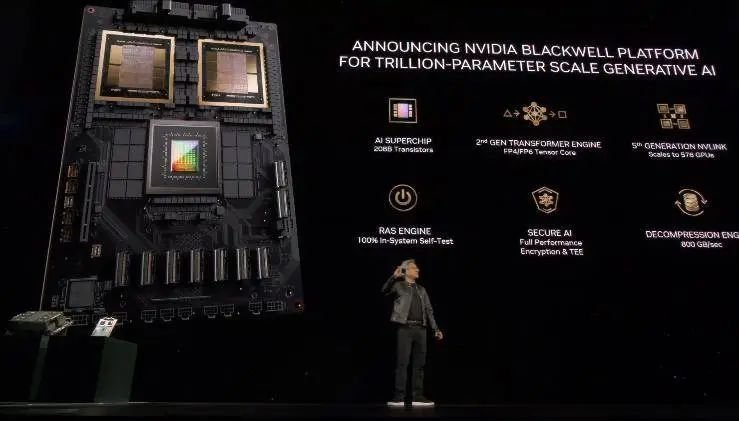

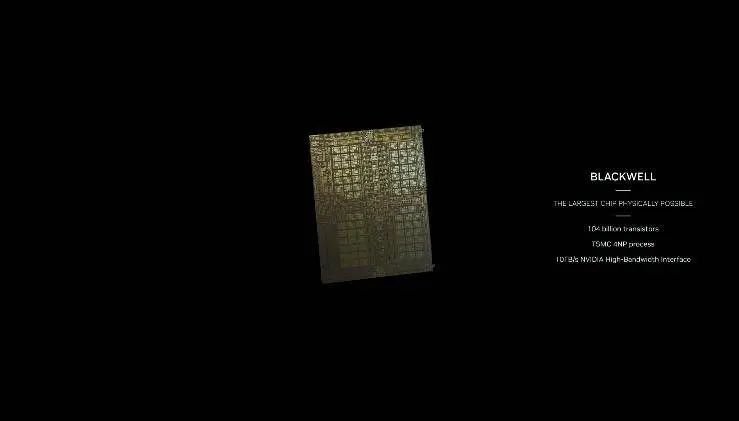

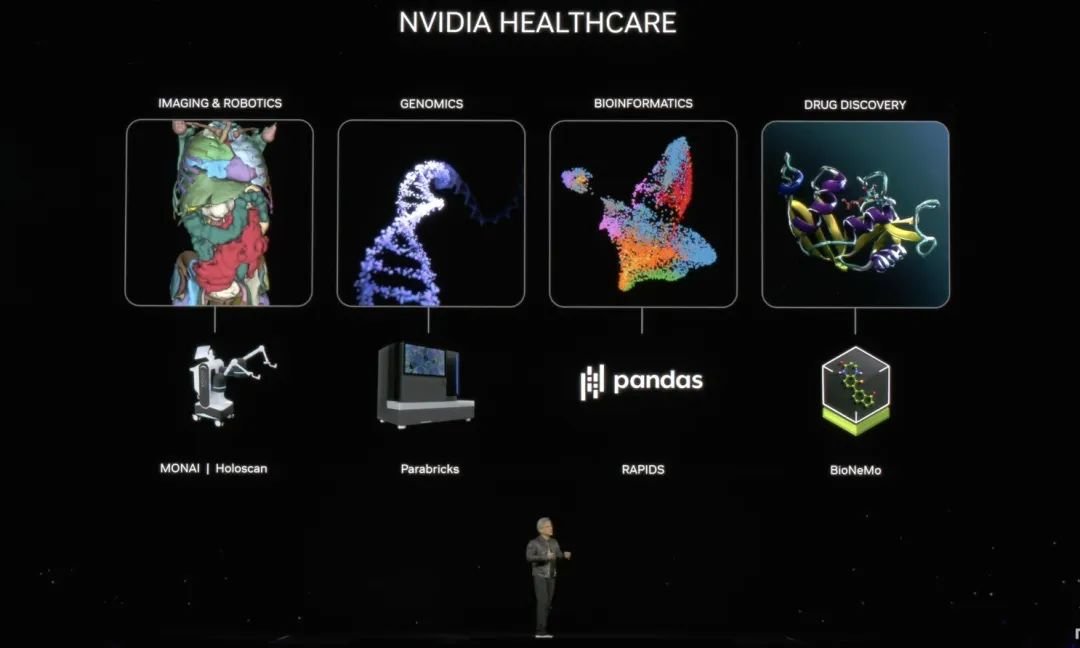

英伟达发布GB200:2080亿晶体管,号称史上最强AI芯片!

27

0

相关文章

近七日浏览最多

最新文章

标签云

三星

黄仁勋

台积电

英伟达

英特尔

amd

芯片供应

微软

谷歌

美股

亚马逊

美国

cpu

芯片

路透社

三星电子

股票

埃利奥特

gpu

史蒂文斯

netflix

保罗

国会

巴菲特

希金斯

国会山

投资收益

美元指数

中概股

美联储

机器人

美光

sk

郑州

苹果

富士康

美债收益率

comex

万军伟

小鹏汽车

道琼斯工业平均指数

a股

马斯克

日元

百胜中国

优步

新东方

科技

上交所

人工智能

初创公司

股票回购

标普

期货

arm

美国商务部

sk海力士

减持

股价

冲高回落

lucid

美国经济

张弛

100指数

显存

显卡

rtx

戴尔

时代周报

应收账款

太阳能电池

rain

游戏

jonathan

john

归母净利润

快科技

npu

处理器

研报

第一财经

ows

matebook

华为

oled

笔记本电脑

ultra

独立显卡

骁龙

高通

光伏发电

adobe

soc

联发科

联发科天玑

siri

ios

mac

iops

pdd

pi

批量

科技巨头

英伟达ceo

blackwell

间谍

情报机关

国家安全部

eco

基准利率

韩国央行

韩国

贵州茅台

京东物流

茅台集团

茅台酒

投资

茅台

工业机器人

半导体

日本央行

无人机

中国

毛利率

摩根士丹利

国际

半导体产业

光刻机

原子弹

neura

外部世界

美国司法部

apple

科学家

自动驾驶

特斯拉

擎天柱

超级工厂

智能驾驶